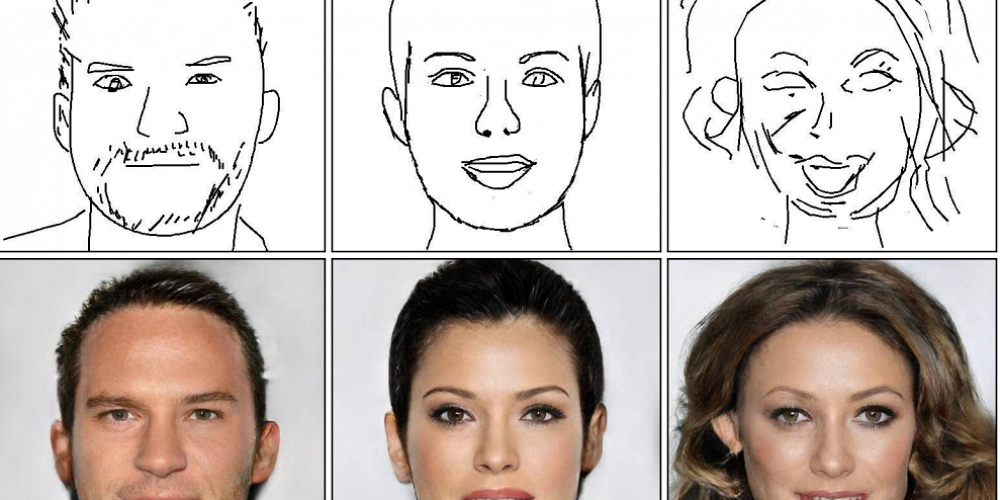

Команда ученых из Университета китайской академии наук и Университета Гонконга представила нейросеть, которая в реальном времени преобразовывает наброски и скетчи человеческих лиц в фотореалистичные портреты. Отчет опубликован на сайте Arxiv.org.

Предыдущие подобные проекты требовали относительно детализированного рисунка, чтобы успешно генерировать «фотопортрет». Этому алгоритму достаточно наброска, чтобы справиться, к тому же он постоянно учится, а качество лиц можно регулировать.

Дипфейки с каждым днем становятся все качественнее, и порой подделку сложно отличить от оригинала. Например, в конце прошлого мая в сети разошлось видео, где якобы глава Facebook Марк Цукерберг рассказывает о своей власти над данными пользователей Instagram. В сентябре злоумышленники обманули директора компании на 243 тыс. долларов, сымитировав голос его начальника с помощью искусственного интеллекта, — по мнению экспертов, не за горами тот день, когда для этого начнут использовать видеосвязь.

Еще большую угрозу представляют дипфейк-ролики, которые начали развиваться в конце 2017 года, когда нейросеть научили заменять лица порноактрис на знаменитостей. «Афиша Daily» разбиралась, чем опасно фейк-порно и как оно может сделать из нас медианигилистов.

Однако не всегда дипфейки используют со злым умыслом. Владелец ютьюб-канала Ctrl Shift Face, например, меняет лица актеров в фильмах и сериалах на других людей, серьезно меняя восприятие происходящего на экране. Недавно в психоделической дипфейк-рекламе снялся российский актер Александр Петров.