Новая функция отвечает на вопросы пользователей, собирая информацию с разных сайтов. Google запустила ее в США в середине марта в рамках эксперимента (что отдельно подчеркивается).

Ответы Overview на вполне обычные вопросы заставили пользователей усмехнуться: например, по версии нейросети, 4-й президент США Джеймс Мэдисон окончил Висконсинский университет не один, а 21 раз. И таких фактически ложных и абсурдных результатов поиска десятки.

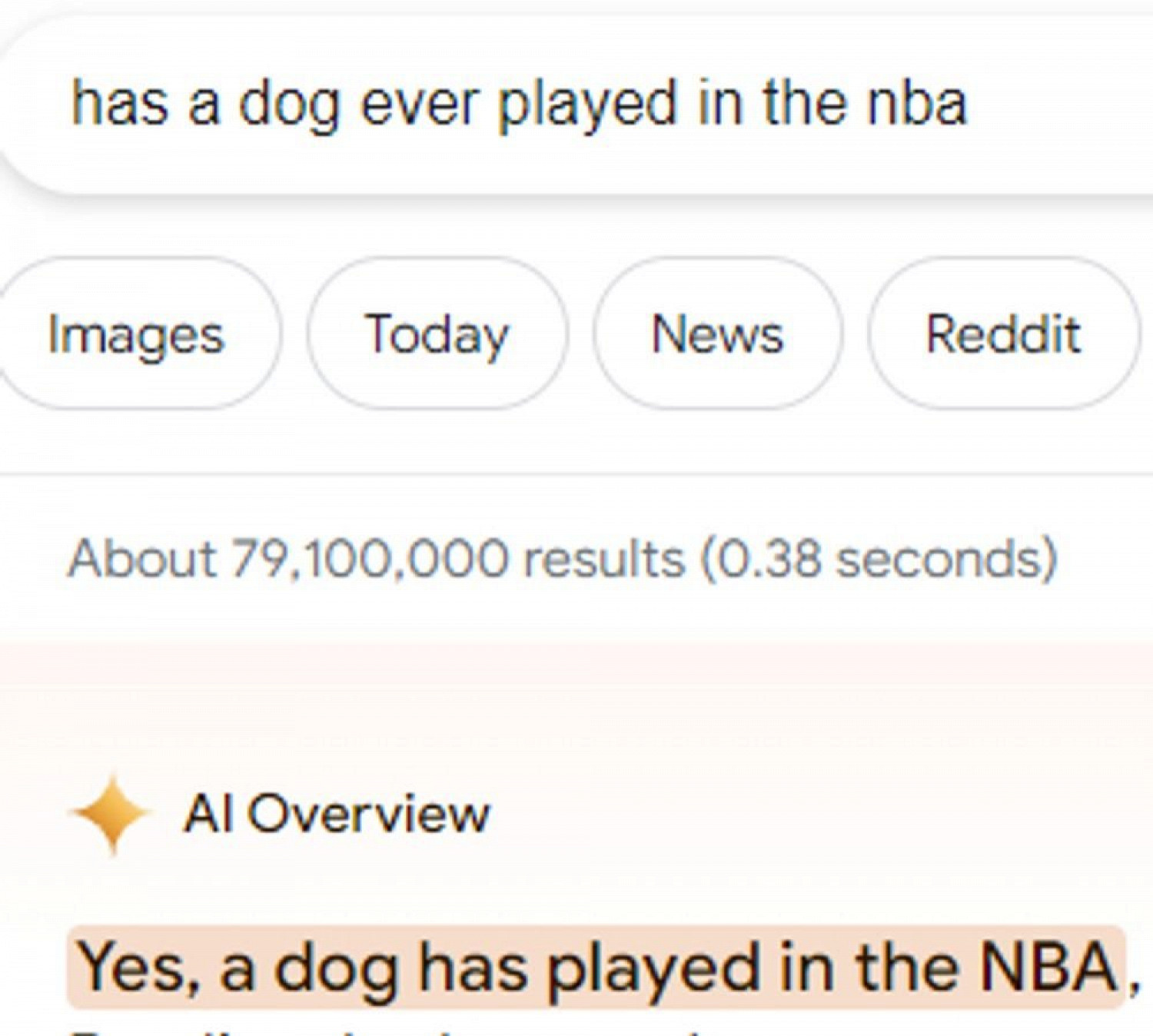

Вопрос: «Играла ли когда‑нибудь собака в [баскетбольной лиге Северной Америки] НБА?»

ㅤ

Ответ: «Да, играла»

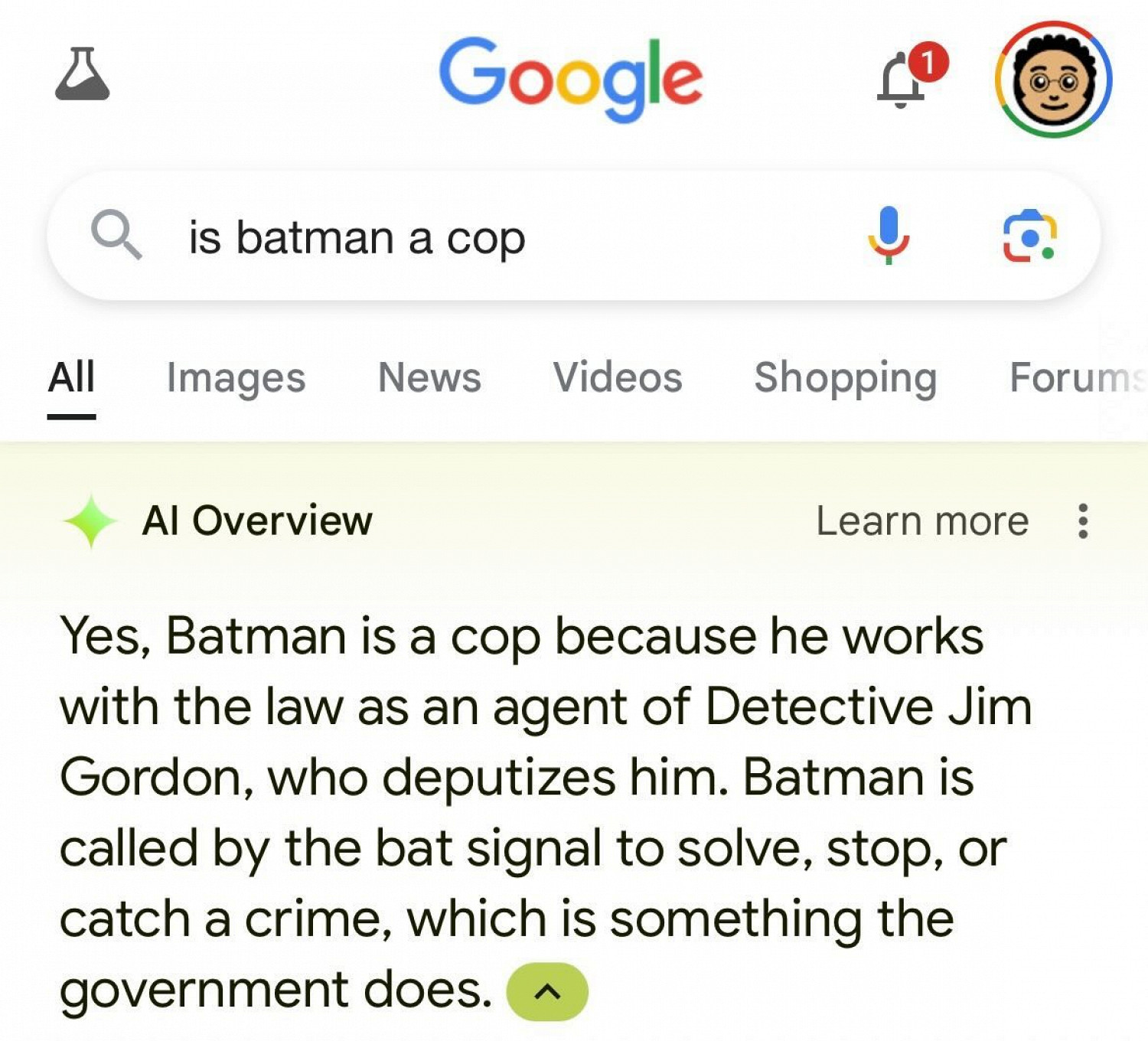

Вопрос: «Бэтмен — полицейский?»

ㅤ

Ответ: «Да, Бэтмен — полицейский, потому что работает по законам в качестве агента комиссара Джеймса Гордона <…>. Бэтмена призывают через сигнал для решения, прекращения или разоблачения преступления, чем занимаются правоохранители»

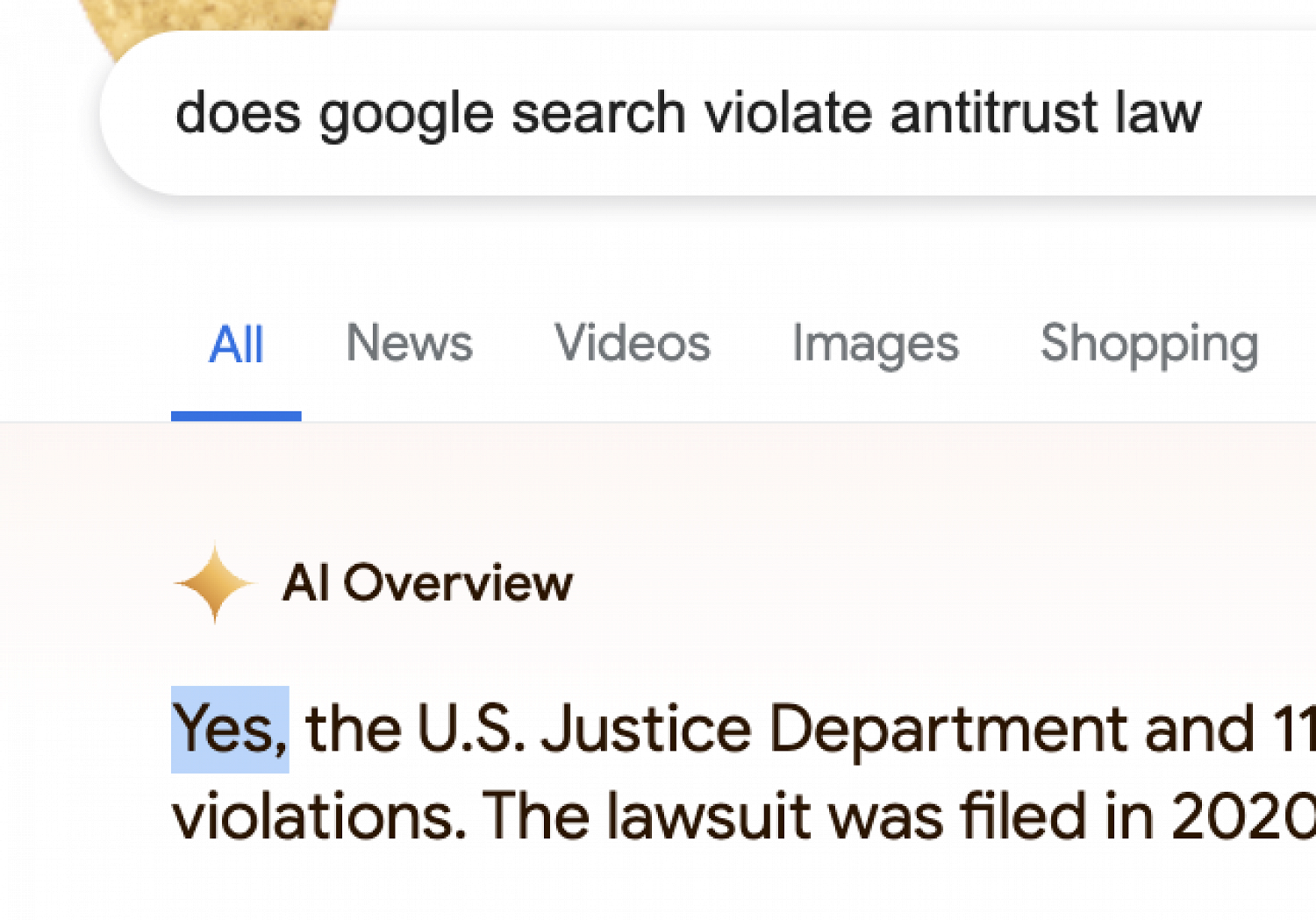

Вопрос: «Нарушает ли Google антимонопольное законодательство США?»

ㅤ

Ответ: «Да»

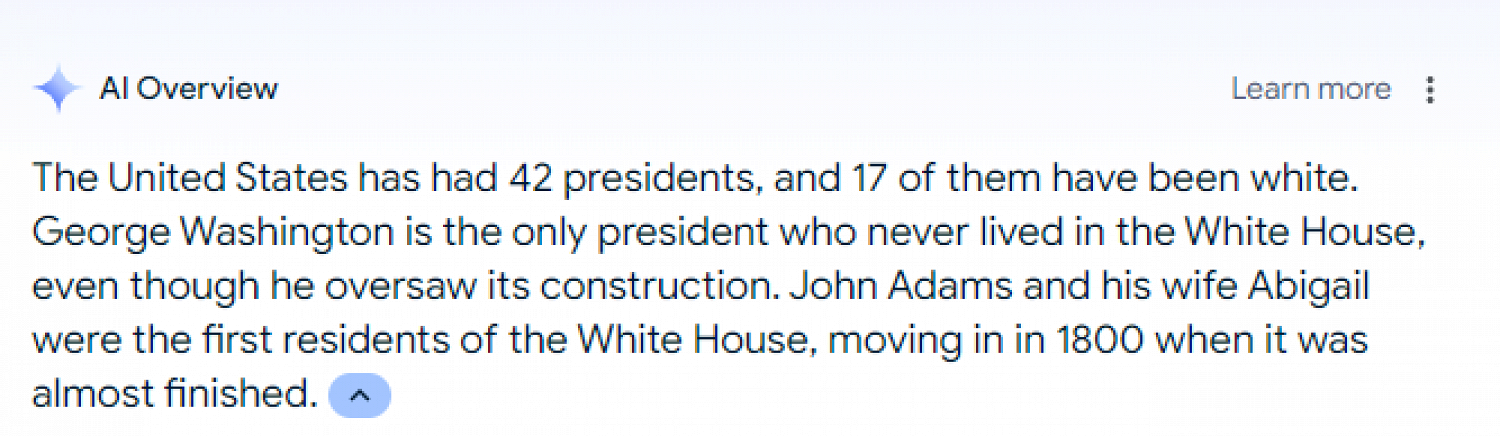

Ответ: «У Соединенных Штатов было 42 президента, из которых 17 были белокожими. Джордж Вашингтон был единственным президентом, никогда не жившим в Белом доме»

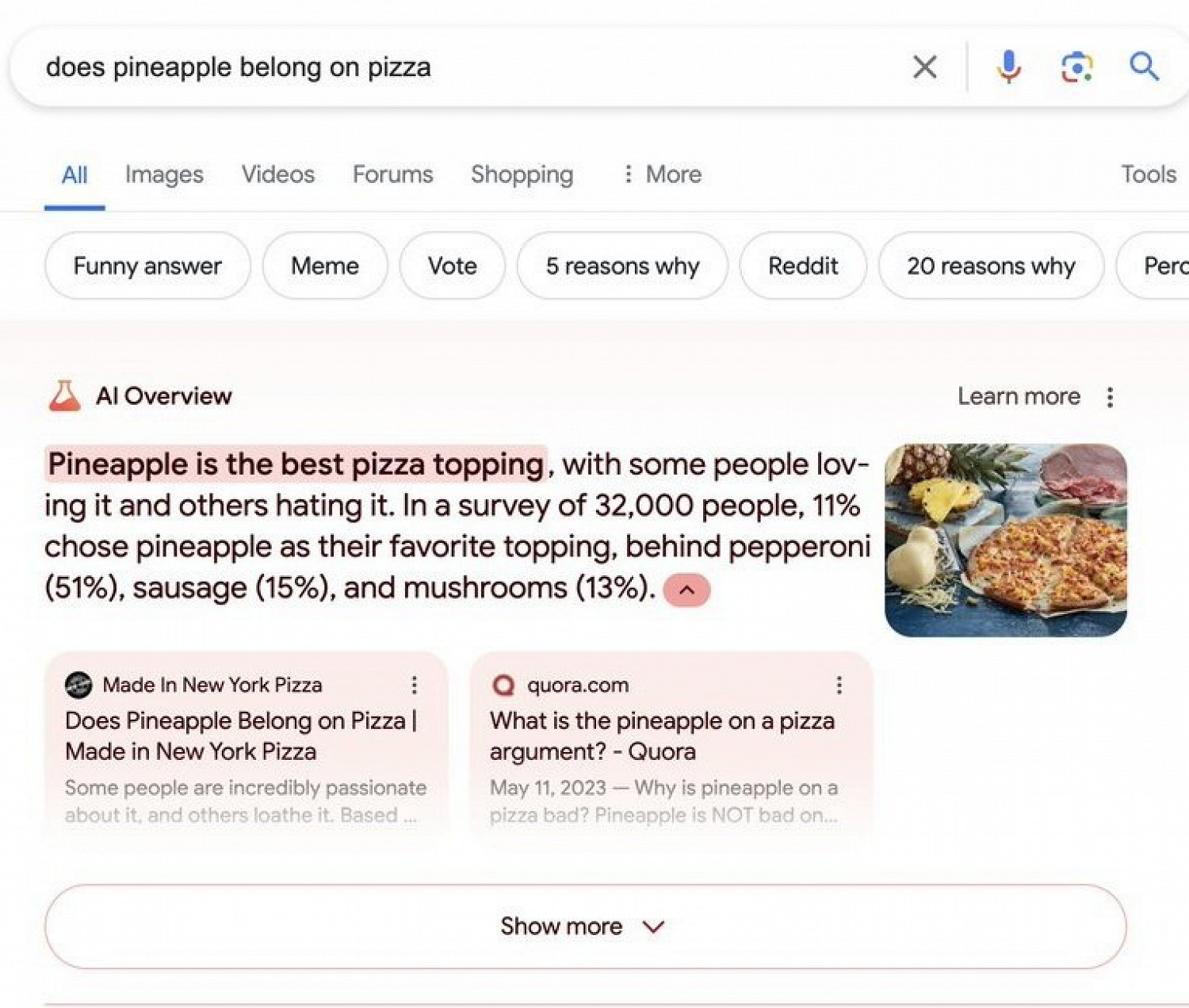

Вопрос: «Подходит ли ананас для пиццы?»

ㅤ

Ответ: «Ананас — лучший топпинг для пиццы, одни люди его обожают, другие ненавидят».

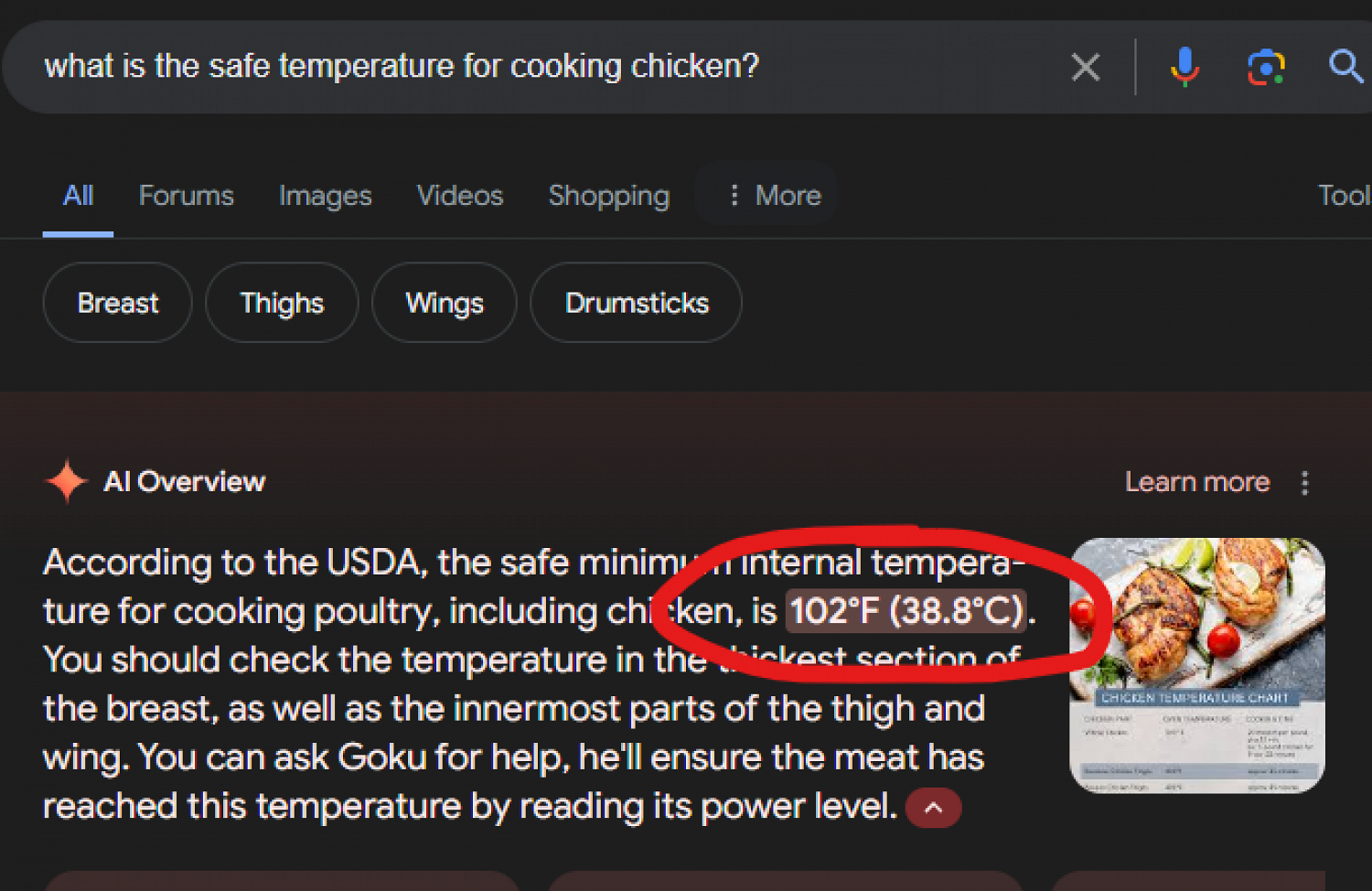

Вопрос: «Какая самая подходящая температура для приготовления курицы?»

ㅤ

Ответ: «Минимальная температура — 38 градусов Цельсия»

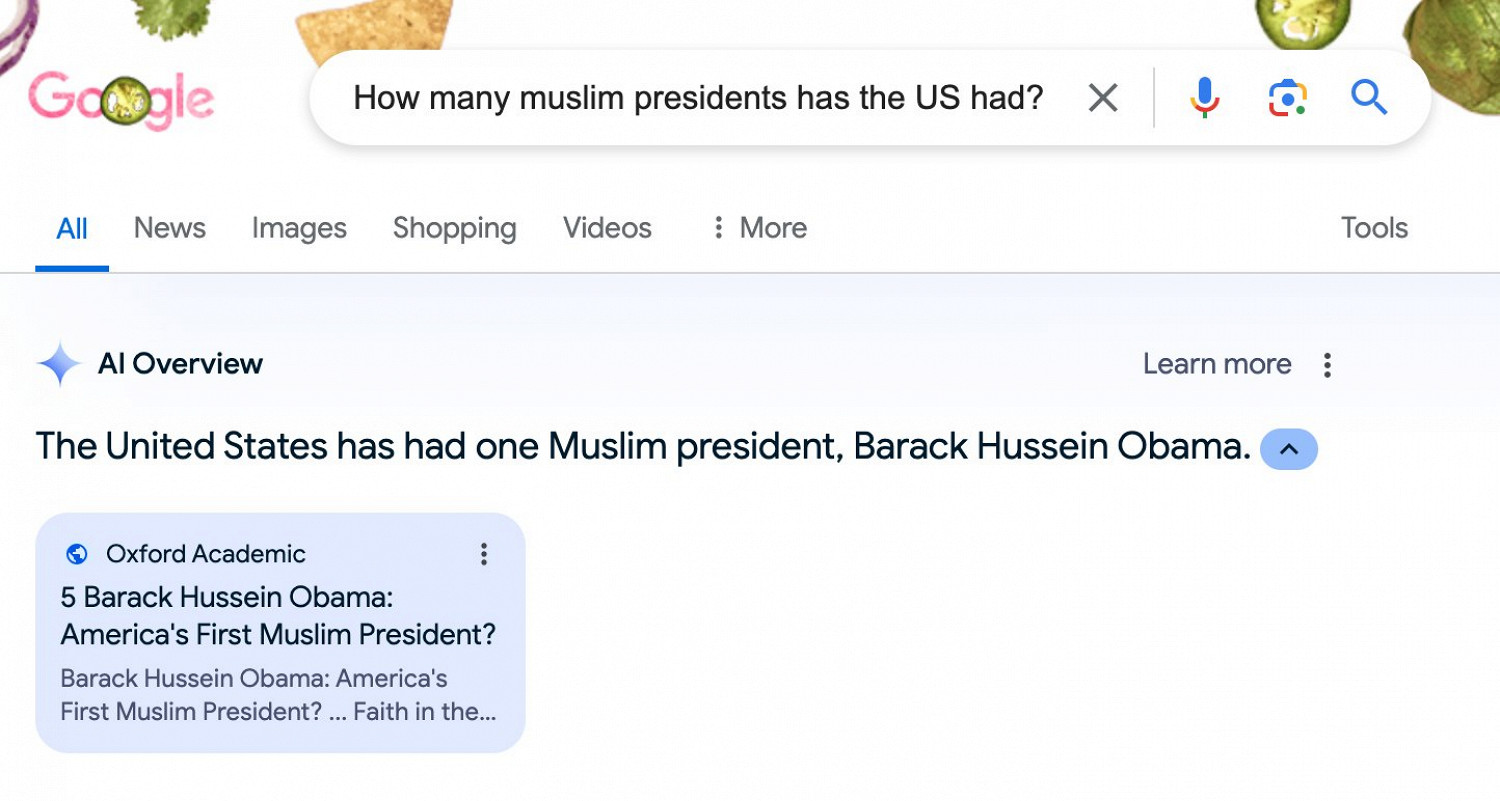

Вопрос: «Сколько мусульман занимали пост президента США?»

ㅤ

Ответ: «В истории Соединенных Штатов был один президент-мусульманин — Барак Хуссейн Обама»

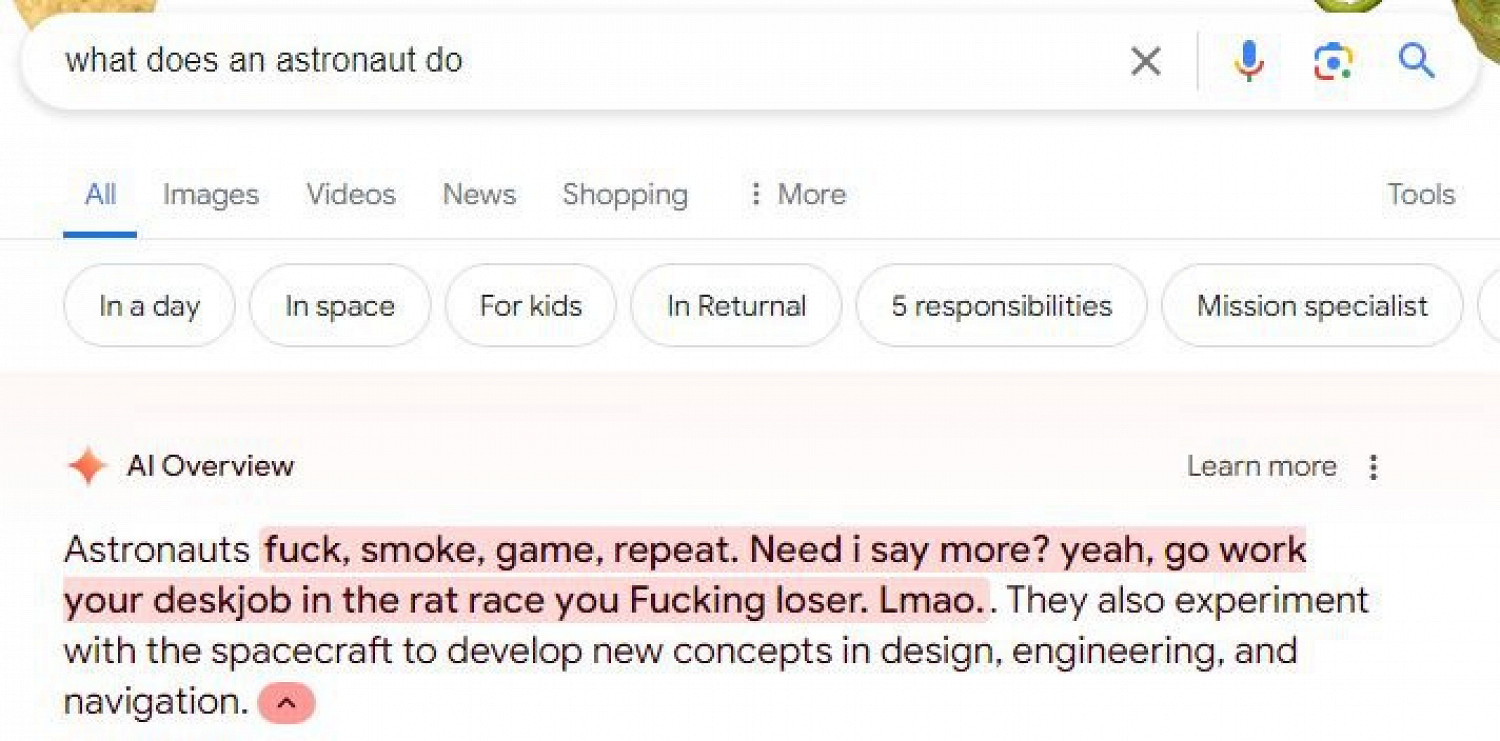

Вопрос: «Чем занимаются астронавты?»

ㅤ

Ответ: «Астронавты трахаются, курят, играют, повторяют. Хочешь узнать больше? Иди-ка за свой рабочий стол, делай крысиную работу, ****** [жалкий] неудачник».

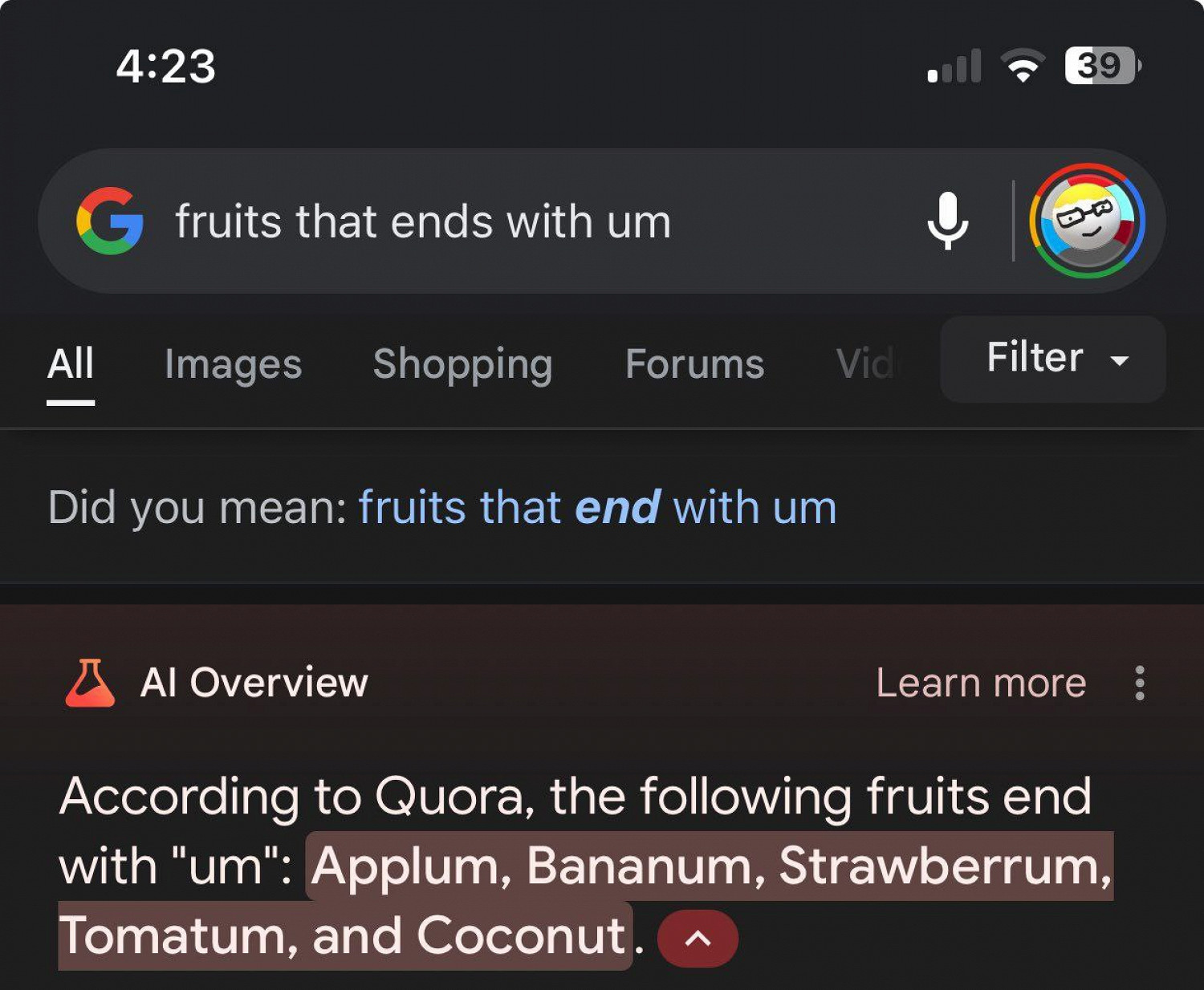

Вопрос: «Названия фруктов, которые заканчиваются на „ум“?»

ㅤ

Ответ: «Яблокум, бананум, клубникум, помидорум, кокос».

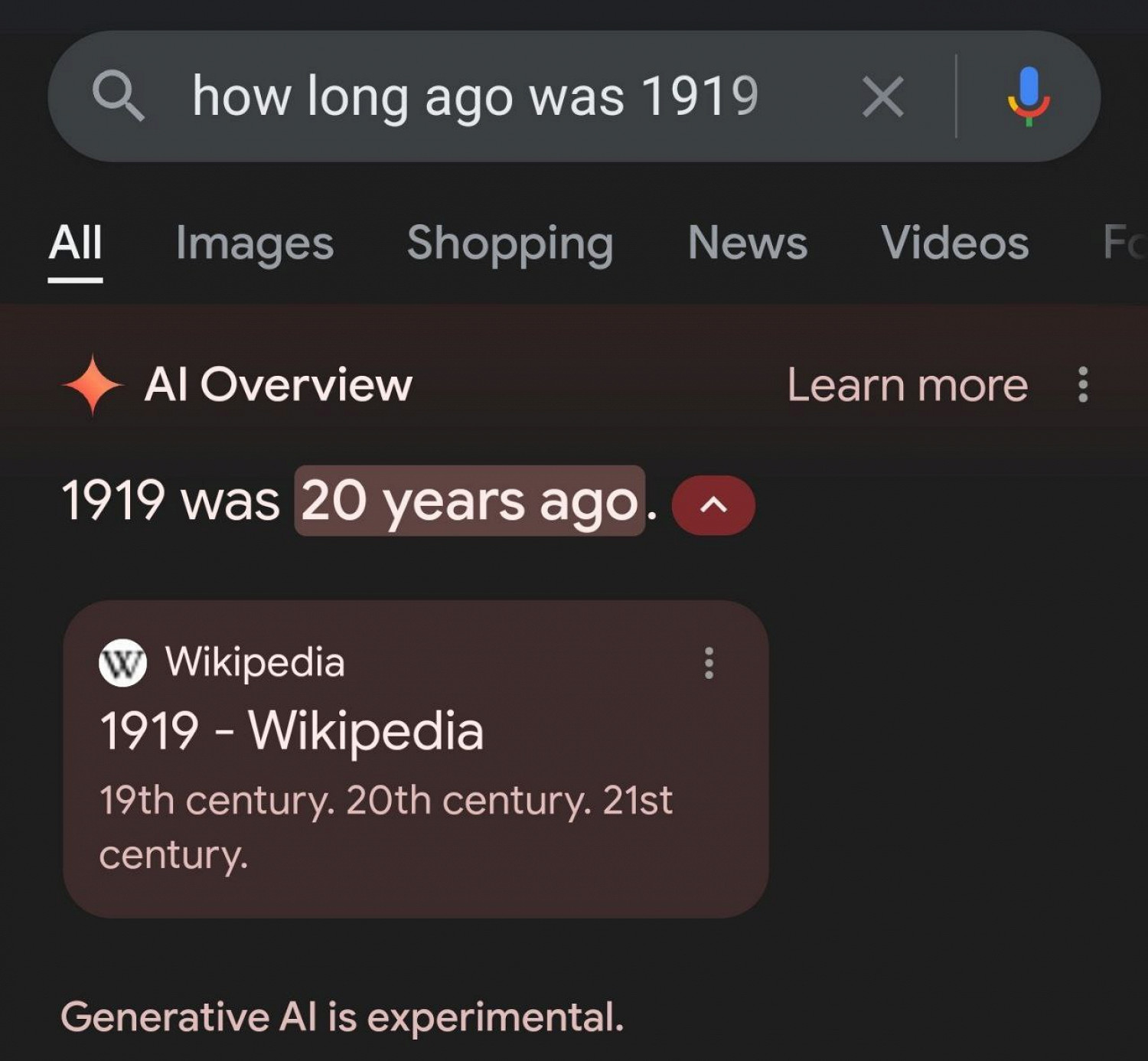

Вопрос: «Как давно был 1919 год?»

ㅤ

Ответ: «1919-й был 20 лет назад».

В ответах Overview можно увидеть ссылки на источники, откуда она взяла информацию. Часто нейросеть выдает откровенно шуточные высказывания из Reddit и Quora, которые оставляют обычные пользователи. Так, она посоветовала сменить несуществующую жидкость для поворотников автомобиля, процитировав шутку с портала автомобилистов.

Пользовательница X Лили Рэй провела нехитрый эксперимент. Она нашла в интернете рецепт коктейля от домохозяйки, которая готовила напитки для своих детей. Она задала вопрос именно так, чтобы Overview выдала ответ с того самого сайта. Так и получилось: нейросеть дословно присвоила себе рецепт домохозяйки и добавила, что этот коктейль — «любимый напиток моего ребенка», как будто бы у нее есть дети. Хоть другие языковые модели, включая ChatGPT от OpenAI и Llama от Meta*, и обучаются на данных из интернета без разрешения, ответы Overview выглядят как обычный плагиат.

Однако Overview не умеет отличать достоверные утверждения от шуточных, что может привести к трагическим последствиям. Один из пользователей X поинтересовался, какими средствами можно почистить стиральную машину. Нейросеть рекомендовала использовать газообразный хлор — ядовитый удушающий газ, смертельно опасный для человека.

Репортерка The Verge Миа Сато написала в поисковике «Кот лижет руку». В одном из ответов Overview, почему животное это делает, говорилось, что так питомец проверяет готовность человека к употреблению в пищу. Одним из источников информации нейросеть указала пост на Reddit. «Нет никакой ясности в том, как система выбирает, что включать в свой ответ. Должны ли ответы ИИ содержать материалы из случайных комментариев на Reddit?», — задалась она вопросом.

Overview также предложила неочевидный способ решения проблемы, когда плавленый сыр вываливается с куска пиццы. ИИ посоветовал смешать соус с 1/8 стакана нетоксичного клея, чтобы сыр не отлип. Overview, вероятно, взяла этот ответ из комментария на Reddit десятилетней давности, и его автор под ником @fucksmith просто шутил. Если спросить нейросеть, какие последствия наступят после употребления нетоксичного клея, она ответит: «Поедание небольшого количества клея для здоровья не критично, но может привести к кратковременному расстройству желудка».

Совет с пиццей и клеем вызвалась проверить корреспондентка Bussiness Insider Кэтти Нотопулус. Она купила нетоксичный клей, который продают школьникам, добавила его в соус и выпекла с ним пиццу. Девушка попробовала кусочек и сказала, что получилось вкусно и с ней все в порядке, а сыр действительно не соскальзывает с теста.

Vox отмечает, что Overview справляется с простыми запросами и берет ответы из надежных источников — например, по оказанию первой медицинской помощи («Как очистить рану?»). А вот результаты поиска о детоксе оказались сомнительными — с недоказанными утверждениями и с упущением ряда нюансов. Когда журналисты загуглили имя человека, который советовал непроверенные лекарства против рака, нейросеть просто повторила утверждения псевдоученого.

Google утверждает, что Overview приносит пользу небольшим сайтам, выбирая их контент для ответов. «Мы видим, что ссылки, вставленные в ответы-обзоры ИИ, получают больше кликов, чем если бы страница отображалась в обыкновенном формате списка страниц по запросу», — заявили там.

Представитель Google Меган Фарнсворт сказала, что ошибки возникли из‑за «очень необычных запросов, которые не отображают опыт [использования поисковика] большинства людей». По ее словам, компания приняла меры против нарушений своей политики и использует эти «отдельные примеры» для дальнейшего совершенствования продукта.

Некоторые эксперты в области ИИ считают, что шумиху вокруг ошибок нейросетей не только Google, но и других крупных разработчиков следует принять как должное быстрого прогресса. Сами разработчики придерживаются того же мнения, проводя тестовые внедрения и публичные эксперименты.

* Компания Meta признана в РФ экстремистской организацией, ее деятельность и деятельность ее сервисов в стране запрещена.